Evasion Attack - Prof. Dr. Norbert Pohlmann

Evasion Attack | |

| Was ist ein Evasion Attack auf eine KI-Lösung?

Voraussetzungen zur Durchführung einer Evasion Attack sind grundlegende Informationen über und (in)direkter Zugriff auf das KI-Modell. In der Regel sind grobe Informationen über die Aufgabe eines KI-Modells, die Repräsentation von Eigenschaften und die Art der Trainingsdaten einem Angreifer bekannt. Der Zugriff auf das KI-Modell kann je nach Anwendungsszenario unterschiedlich ausgestaltet sein:

Zusätzlich besteht oftmals die Möglichkeit, mit öffentlichen Datensätzen ein ähnliches KI-Modell zu trainieren und dieses zur Vorbereitung eines Adversarial Example zu verwenden. Zu diesem Zweck wird die sogenannte Übertragbarkeitseigenschaft (engl. transferability property) verwendet. In der KI-Domäne besagt diese Eigenschaft, dass ein Adversarial Example, das bei einem KI-Modell funktioniert, mit hoher Wahrscheinlichkeit auch bei einem anderen KI-Modell funktionieren wird, wenn beide KI-Modelle auf die gleiche Aufgabe trainiert wurden. Effektiv ist dies mit einem direkten Zugriff auf das Ziel-Modell gleichzusetzen. Schutzmaßnahmen gegen eine Evasion AttackDie Annahme, dass durch Geheimhaltung von Details über die Implementierung und das Training eines KI-Modells Angriffe erheblich erschwert werden, ist fraglich. Denn schon durch Kenntnis der Aufgabe eines KI-Modells lassen sich Informationen wie Modell-Architektur, Trainingsalgorithmus, Art der Trainingsdaten und die Eigenschaftsrepräsentation (zumindest ungefähr) ableiten. Des Weiteren steht für die meisten Anwendungsszenarien ein entsprechender Trainingsdatensatz öffentlich zur Verfügung. In der Praxis hat ein Angreifer oftmals auch Zugriff auf ein Orakel. Sinnvolle Schutzmaßnahmen sollten dieses Angreifermodell berücksichtigen und diesem standhalten. Eine Verwundbarkeit gegen Adversarial Examples kann nie gänzlich ausgeschlossen werden. KI-Modelle sind in der Regel fehlerbehaftet, weil nicht alle Prädiktoren erfassbar sind. Es stellt eine Herausforderung dar, während des Trainings alle Areale im Eigenschaftsraum zu explorieren. Zudem gibt es in vielen Domänen Grenzfälle, für die eine eindeutige Vorhersage schwierig ist. Manchmal sind sich selbst Domänenexperten nicht einig, welches Label zu vergeben ist. Insbesondere, wenn konkurrierendes Verhalten (z. B. die Erkennung von Spam) gelernt werden soll, ist anzunehmen, dass Adversarial Examples nicht ausgeschlossen werden können. Daher ist ein gutes Verständnis der vorliegenden Daten und des zu lösenden Problems unerlässlich für das Design eines robusten KI-Modells. Aufgrund der Vielzahl an Einsatzmöglichkeiten für KI, ist die Erstellung einer universellen Liste von Schutzmaßnahmen nicht möglich. Jedoch gibt es einige Maßnahmen, die auf viele KI-Modelle angewendet werden können:

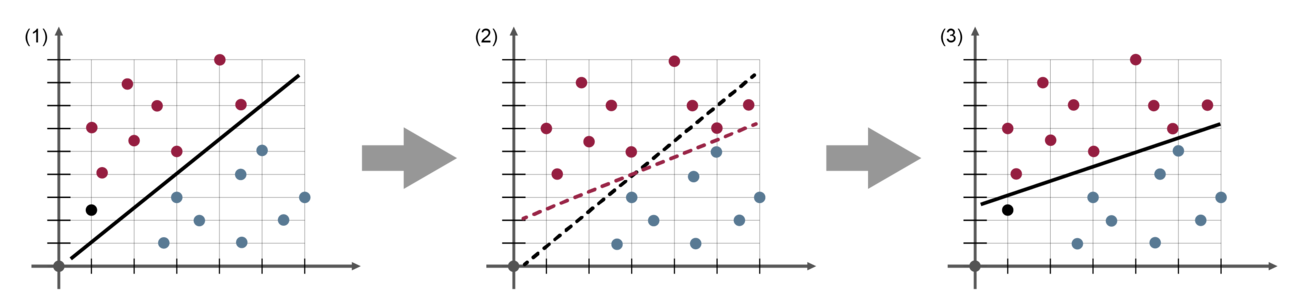

Eine vorangegangene Poisoning Attack kann eine Evasion Attack begünstigen. Indem die Gewichtung von Prädiktoren verändert wird, ist es möglich, dass die Erstellung von Adversarial Examples einfacher ausfallen oder bestimmte Eingaben zu einem Adversarial Example werden. Zum Beispiel kann ein Angreifer gezielte E-Mails senden, sodass sich ein Spamfilter dahingehend verändert, dass eine bestimmte Spam-Mail übersehen wird, die zuvor erkannt worden wäre. In der Abbildung ist dieses Vorgehen konzeptionell dargestellt.

Angriffe auf die Künstliche Intelligenz  Weitere Informationen zum Begriff “Evasion Attack”:

„Angriffe auf die Künstliche Intelligenz – Bedrohungen und Schutzmaßnahmen“ „Künstliche Intelligenz und Cybersicherheit – Unausgegoren aber notwendig“ „Ethik und künstliche Intelligenz – Wer macht die Spielregeln für die KI?“ „Der Virtuelle IT-Sicherheitsberater – Künstliche Intelligenz (KI) ergänzt statische Anomalien“ „Angriffe auf die Künstliche Intelligenz – Bedrohungen und Schutzmaßnahmen“ „Wie können wir der KI vertrauen? – Mechanismus für gute Ergebnisse“ „Sei gewarnt! Vorhersage von Angriffen im Online-Banking“ „Übungsaufgaben und Ergebnisse zum Lehrbuch Cyber-Sicherheit“ „Bücher im Bereich Cyber-Sicherheit und IT-Sicherheit zum kostenlosen Download“

„AI for IT security and IT security for AI“ „Künstliche Intelligenz (KI) und Cyber-Sicherheit“ „Immer mehr Daten = Immer mehr (Un) Sicherheit?“ „Cyber-Sicherheit vor dem Hintergrund von Krisensituationen“

„Master-Studiengang Internet-Sicherheit (IT-Sicherheit, Cyber-Sicherheit)“ „Marktplatz IT-Sicherheit: IT-Notfall“ „Marktplatz IT-Sicherheit: IT-Sicherheitstools“ „Marktplatz IT-Sicherheit: Selbstlernangebot“ „Marktplatz IT-Sicherheit: Köpfe der IT-Sicherheit“ „Vertrauenswürdigkeits-Plattform“ Zurück zur Übersicht Summary  Article Name Evasion Attack Description Ziel einer Evasion Attack ist die Erstellung einer Eingabe, die eine falsche oder spezifische Entscheidung verursacht. Eine solche Eingabe wird als Adversarial Example bezeichnet. Author Prof. Norbert Pohlmann Publisher Name Institut für Internet-Sicherheit – if(is) Publisher Logo  |

| |