Ethik der Künstlichen Intelligenz - Prof. Dr. Norbert Pohlmann

Ethik der Künstlichen Intelligenz | |

| Inhaltsverzeichnis Was ist Ethik der Künstlichen Intelligenz?

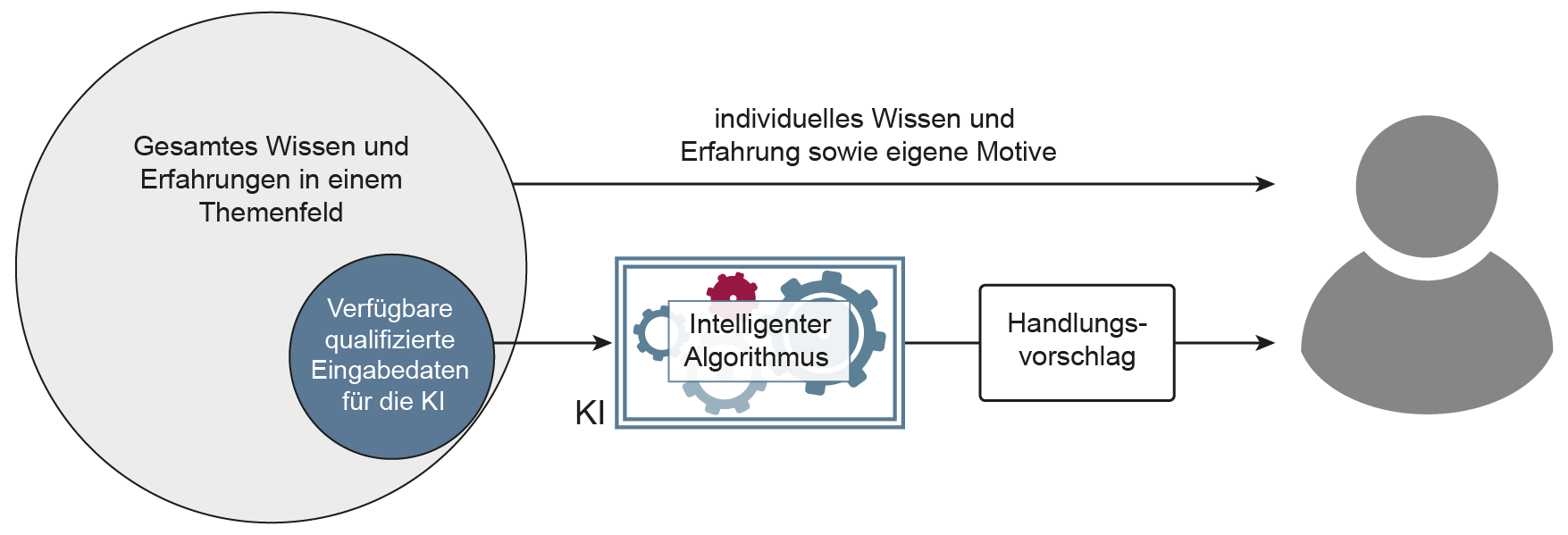

Da Künstlichen Intelligenz auch im Bereich Cyber-Sicherheit eingesetzt wird, ist es notwendig, den Einsatz von KI auch in diesem Kontext unter ethischen Aspekten zu bewerten. Stand der öffentlichen DiskussionMomentan ist der Tenor der meisten Artikel zum Thema Künstliche Intelligenz (KI) relativ konformistisch. Unverzüglich wird der Leser dahingehend sensibilisiert, dass sich hierdurch enorme Chancen auftun, die nicht ungenutzt bleiben dürfen, um international nicht abgehängt zu werden. Eher nebenbei erwähnt wird, dass trotz aller Euphorie auch die Risiken in Betracht zu ziehen seien. Da aus diesen jedoch Implikationen für die gesamte Gesellschaft resultieren können, ist es nicht nur ratsam, sondern erforderlich, den Einsatz von KI in allen Bereichen – auch im Kontext der IT-Sicherheit – unter ethischen Aspekten zu bewerten. Unbestritten liegen die Vorteile beim Einsatz von KI auf der Hand: Mittels KI-Algorithmen können unter anderem Unternehmensprozesse effizienter gestaltet, Kosten eingespart oder auch Fehlerquellen im Produktionsablauf detektiert und beseitigt werden. Alles gute Argumente, die für einen extensiven Einsatz von KI sprechen.  Woraus sollte also die Notwendigkeit einer Ethik-Diskussion resultieren?Auch dafür gibt es substanzielle Gründe: Ein wesentlicher ist, dass weltweit Konsumenten, denen im Regelfall der Einblick in die Technologie sowie die notwendigen Grundlagen für deren Folgenabschätzung fehlt, Unternehmen in der Verantwortung sehen, unter anderem KI ethisch vertretbar einzusetzen. Somit sind die Mitgestalter der digitalen Evolution im Prinzip gefordert – nicht nur hinsichtlich ihres Unternehmens, sondern gleichwohl im Sinne des Einzelnen als auch der Gesellschaft – gewissenhaft zu handeln. Diese Verantwortlichkeit resultiert nicht zuletzt daraus, dass im Speziellen der Einsatz von KI nicht nur dem einzelnen Nachteile bringt, sondern ganzen Gesellschaften massiv Schaden zufügen kann. Denn während einer Person hierdurch eventuell ein Verlust bezüglich der digitalen Sicherheit, Privatsphäre, Reputation oder auch die Verletzung des Grundsatzes der Gleichbehandlung droht, potenzieren sich die möglichen Folgen für die Gesellschaft um ein Vielfaches. Angefangen bei der Schwächung der Wirtschaftskraft eines Landes. Aufgrund der zunehmenden Komplexität sowie dem Einsatz von KI bei Folglich sollten potenzielle Unwägbarkeiten, die aus dem Einsatz resultieren können, tatsächlich genauer betrachtet werden. Denn de facto ist in einigen Bereichen der Reifegrad der Technologie so gering, dass die Effekte, die aus deren Einsatz möglicherweise resultieren, sich noch nicht umfassend prognostizieren lassen. Anhand von Beispielen, die bereits in der Entwicklung weiter fortgeschritten sind – wie etwa das selbstfahrende Automobil – zeigt sich jedoch, wie groß hier der Diskussionsbedarf ist; zum Beispiel im Hinblick auf die Bewertung fehlerhafter Entscheidungen, die unter anderem zur Verursachung von Unfällen geführt haben, und möglicher Konsequenzen durch den Verlust der Vertraulichkeit bezüglich der Mobilität. Künstliche Intelligenz für Cyber-Sicherheit ist auch eine Frage der EthikDa nicht nur aus dem Einsatz von KI neue Schwachstellen resultieren, sondern auch neue Angriffsmöglichkeiten auf Staat und Unternehmen realisierbar sind, erscheint es als eine logische Schlussfolgerung kriminelle Attacken auf gleicher Ebene abzuwehren. Das heißt, mithilfe von KI den Schutz von IT-Systemen und IT-Infrastrukturen zu gewährleisten. Obwohl KI im Kontext der IT-Sicherheit unweigerlich als probates Mittel zur Abwehr scheint, ist auch hier – wie bei jedem Einsatz der KI – die Frage zu diskutieren, in welchem Rahmen dies angemessen ist. Warum dieser Diskurs nötig ist und welche Forschungsfragen in diesem Kontext zu bearbeiten sind, wird nachfolgend exemplarisch anhand von drei Szenarien aus dem Bereich des Schutzes der IT dokumentiert. 1. Privatheit vs. Allgemeinwohl: Problem Schutz von Daten Die Berücksichtigung der Annahme, dass mittels KI eine Optimierung der Cyber-Sicherheitsmaßnahmen realisierbar ist, bedeutet, dass ein Angriff schneller und präziser detektiert werden kann, je mehr Daten mit sicherheitsrelevanten Informationen zur Verfügung stehen. Daraus lässt sich im Weiteren auch ableiten, dass für eine bestmögliche Kennung in bestimmten Fällen die Einbeziehung personenbezogener Daten von Mitarbeitern unverzichtbar ist. Viele Angriffe werden mithilfe von Social Engineering und Malware über die Endgeräte der Mitarbeiter indirekt durchgeführt. Eine Notwendigkeit für deren Hinzunahme könnte sich zum Beispiel für den Fall ergeben, wenn ein Energieversorger angegriffen wird, da dies eine präzise Ursachenforschung für die schnellstmögliche Reaktion zur Gewährleistung der Stromversorgung verlangt. Der Bedarf ist theoretisch nachvollziehbar – andererseits werden dadurch die Individualrechte außer Kraft gesetzt, da die Nutzung von personenbezogenen Daten durch die DSGVO exakt limitiert ist. Im konkreten Fall würde dies bedeuten, dass durch eine Analyse der Daten parallel das Verhalten der Mitarbeiter ausgewertet und somit deren Privatsphäre verletzt wird. Daraus resultiert folgendes Dilemma: Die digitale Ethik fordert, dass keine grundlegenden Rechte wie die Privatheit zugunsten eines höheren Ziels völlig aufgegeben werden dürfen. Dagegen steht die Prämisse des Strebens nach dem (maximierten) Gesamtnutzen für die Gesellschaft. Aus dieser resultiert dann zwangsläufig die Fragestellung, wann es angeraten oder sogar unabdingbar ist, die Rechte des Individuums zugunsten des Wohles für die Gemeinschaft aufzuheben. Eine mögliche Annäherung zur Auflösung dieses Dilemmas wäre, hierfür Grenzen zu definieren, indem Kriterien dafür festgelegt werden, wann das Individualrecht nachrangig zu behandeln ist. Hierfür bedarf es unter anderem der Forschung bezüglich der Wertvorstellungen, auch um sicherzustellen, dass die Wertmaßstäbe zur Beurteilung mit den höheren Zielen einer Gesellschaft konform sind. 2. Neutralität vs. Voreingenommenheit: Problem Bias Aufgrund der Quantität als auch Vielfältigkeit an Angriffsarten, mit denen Unternehmen und insgesamt staatliche Institutionen tagtäglich attackiert werden, erscheint es sinnvoll, den IT-Sicherheitsverantwortlichen mithilfe von KI Unterstützung zu bieten. Diese könnte dergestalt sein, dass automatisiert eine Selektion der zehn gravierendsten Bedrohungen inklusive Handlungsempfehlungen zur Verfügung gestellt werden, die dann priorisiert im Sinn der optimalen Schadensbegrenzung umsetzbar sind. Obwohl diese Vorgehensweise per se sinnvoll erscheint, entsteht daraus jedoch potenziell ein Dilemma in Bezug auf die richtige Handlungsweise, allein basierend auf der Tatsache einer algorithmischen Voreingenommenheit beziehungsweise Verzerrung. Denn die Auswahl der sicherheitsrelevanten Daten, geprägt unter anderem durch Erfahrungswerte aus der Vergangenheit und/oder Vorurteile, beeinflusst die zukünftigen Ergebnisse. Das wird zum Beispiel deutlich an statistischen Analysen im Kontext der Polizeiarbeit in den USA. Die Annahme, dass eine bestimmte Bevölkerungsgruppe eher zu Straftaten neigt, legt den Fokus auf diese und wird dann kontinuierlich anhand aktualisierter Werte weiter bestätigt. Analog dazu wäre es beispielsweise vorstellbar, dass komplexe Angriffe auf Institutionen bevorzugt mit China in Verbindung gebracht werden. Dies hätte dann zur Folge, dass ein Hauptaugenmerk auf Angriffe aus diesem Land läge, die automatisch als gravierender bewertet würden, inklusive obligatorischer Vorgaben für die Ergreifung entsprechender Maßnahmen. Die Analyse, ob es der Realität entspräche oder ob der Angriff einer anderen Nation viel kritischer einzustufen wäre, würde dann sekundär. Da sich im Einzelfall aus der Masse der vorliegenden sicherheitsrelevanten Daten nicht ad hoc entscheiden lässt, ob seitens der KI die richtigen Präferenzen getroffen worden sind, besteht hier ein Forschungsbedarf dahingehend, wie die algorithmische Voreingenommenheit auf ein Minimum reduzierbar ist. Dabei ist unter anderem relevant zu untersuchen, wie Entscheidungen – unabhängig von Vorurteilen, Vergangenheitswerten oder einem bestimmten (wirtschaftlichen/gesellschaftlichen) Kontext – getroffen werden können. 3. Strike Back: Problem Unvollständigkeit der Daten Dem Konstrukt des ‚Strike Back’ liegt die Hypothese zugrunde, dass ein Angriff durch einen Gegenangriff beendet werden kann. Unter Einsatz von KI wäre es theoretisch möglich, eine vollkommen neutrale Einschätzung zu ermitteln, was unternommen werden müsste, um den Angreifer zum Aufgeben zu motivieren. Die ethische Frage in diesem Kontext dreht sich um den Begriff der Neutralität und ob es überhaupt möglich ist, die Vollständigkeit der Daten zu erreichen, um eine ausgewogene und verantwortliche Entscheidung durch KI-Systeme errechnen zu lassen. Davon ausgehend, dass ein Strike Back automatisiert erfolgt, könnte möglicherweise ein Schaden auf einer höheren Ebene angerichtet werden, der moralisch nicht vertretbar wäre – wie etwa ein Gegenschlag, der gleichzeitig auch die Stromversorgung eines Krankenhauses lahmlegen würde. Fragestellungen wie diese zeigen den eklatanten Forschungsbedarf dahingehend auf, inwieweit es leistbar ist, vertrauenswürdige KI-Systeme zu entwickeln, die den Schutz der Zivilgesellschaft gewährleisten können. Fazit der Ethik bezogen auf KI und Cyber-SicherheitBeim Einsatz von KI im Bereich der Cyber-Sicherheit muss der gesellschaftliche Diskurs in zwei Richtungen geführt werden. Zum einen dahingehend, welchen Stellenwert die Cyber-Sicherheit einnehmen soll. Hierzu gehören auch inhaltliche Definitionen wie „Welche Werte sollen durch sie gewahrt werden“ (etwa physische Unversehrtheit oder ökonomisches Wohlergehen) oder auch „Ab welchem Grad der Cyber-Sicherheit gilt eine Situation als sicher“. Denn dies hat Auswirkungen darauf, was für eine Gesellschaft akzeptabel ist, beispielsweise der automatisierte Einsatz von Strike Back. Zum anderen werfen die Szenarien die Frage auf, wie weit es möglich ist, sich auf Technologie – etwa KI – zu verlassen. Nachvollziehbarkeit von Entscheidungen als Prinzip der Künstliche IntelligenzEs ist unklar, ob KI-Systeme eine perfekte Lösung sein können. Aufgrund der Komplexität sowie der schnellen Weiterentwicklung scheint es angemessen, den Mensch bei wichtigen Anwendungen als kontrollierenden Faktor einzubinden. Ganz nach dem Grundsatz „Keep the human in the loop”.  Wie in der Abbildung zu erkennen ist, sind bei den meisten KI-Anwendungen die Eingabedaten immer nur ein Teil des gesamten Wissens und Erfahrungen in einem Themenfeld. Idealerweise sind die verfügbaren qualifizierten Eingabedaten für die KI besonders signifikant, um ein gutes Ergebnis zu erzielen. Dennoch kann ein KI-System nicht alle Daten nutzen, weil sie nicht als Daten verfügbar sind, oder der Aufwand viel zu groß ist, diese verfügbar zu machen. Folglich sollte das Ergebnis eines KI-Systems stets als Handlungsempfehlung verstanden werden und es muss sichergestellt sein, dass der Mensch jederzeit entscheiden kann, ob er dieser folgt oder nicht. Damit wird die Selbstbestimmtheit und Souveränität der Menschen gefördert sowie gleichzeitig die Vertrauenswürdigkeit in KI-Systeme erhöht. Angriffe auf die Künstliche Intelligenz  Weitere Informationen zum Begriff “Ethik der Künstlichen Intelligenz”:

„Angriffe auf die Künstliche Intelligenz – Bedrohungen und Schutzmaßnahmen“ „Künstliche Intelligenz und Cybersicherheit – Unausgegoren aber notwendig“ „Ethik und künstliche Intelligenz – Wer macht die Spielregeln für die KI?“ „Der Virtuelle IT-Sicherheitsberater – Künstliche Intelligenz (KI) ergänzt statische Anomalien“ „Angriffe auf die Künstliche Intelligenz – Bedrohungen und Schutzmaßnahmen“ „Wie können wir der KI vertrauen? – Mechanismus für gute Ergebnisse“ „Sei gewarnt! Vorhersage von Angriffen im Online-Banking“ „Übungsaufgaben und Ergebnisse zum Lehrbuch Cyber-Sicherheit“ „Bücher im Bereich Cyber-Sicherheit und IT-Sicherheit zum kostenlosen Download“

„AI for IT security and IT security for AI“ „Künstliche Intelligenz (KI) und Cyber-Sicherheit“ „Immer mehr Daten = Immer mehr (Un) Sicherheit?“ „Cyber-Sicherheit vor dem Hintergrund von Krisensituationen“

„Master-Studiengang Internet-Sicherheit (IT-Sicherheit, Cyber-Sicherheit)“ Zurück zur Übersicht Summary  Article Name Ethik der Künstlichen Intelligenz Description Die Ethik der Künstlichen Intelligenz ist ein Teilbereich der angewandten Ethik und befasst sich mit Fragen des menschlichen Handels in diesem Bereich. KI in der Cyber-Sicherheit muss auch unter ethischen Aspekten bewertet werden. Author Prof. Norbert Pohlmann Publisher Name Institut für Internet-Sicherheit – if(is) Publisher Logo  |

| |