ChatGPT und Cyber-Sicherheit - Prof. Dr. Norbert Pohlmann

ChatGPT und Cyber-Sicherheit | |

| Inhaltsverzeichnis Welchen Einfluss hat ChatGPT auf die Cyber-Sicherheit?

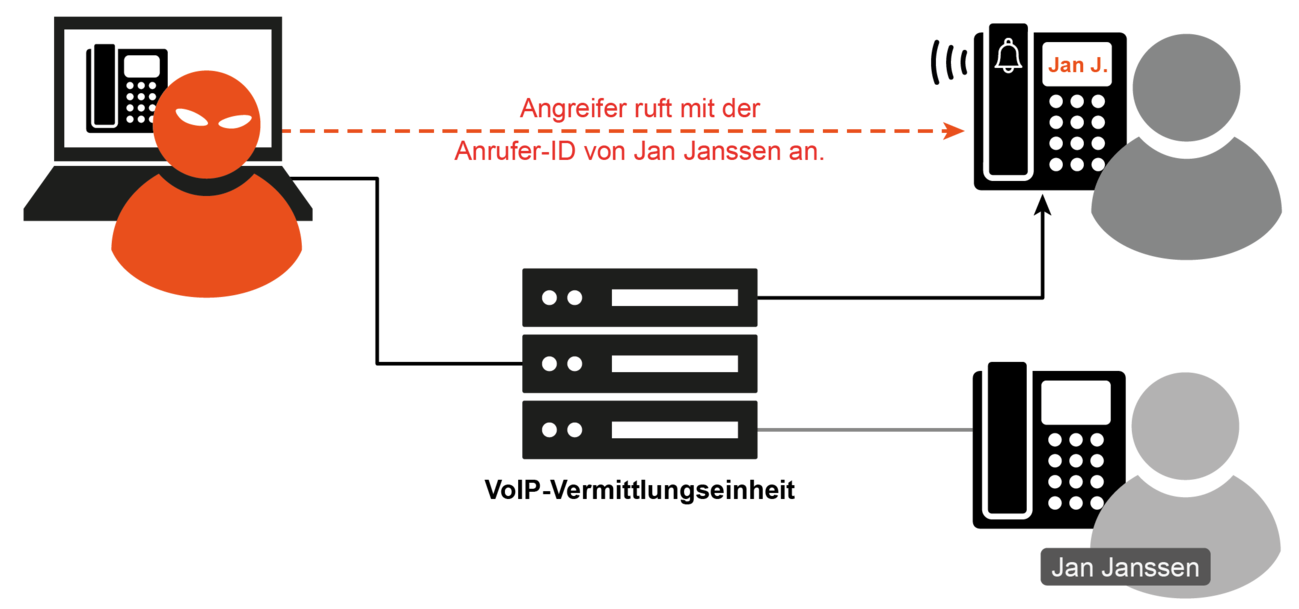

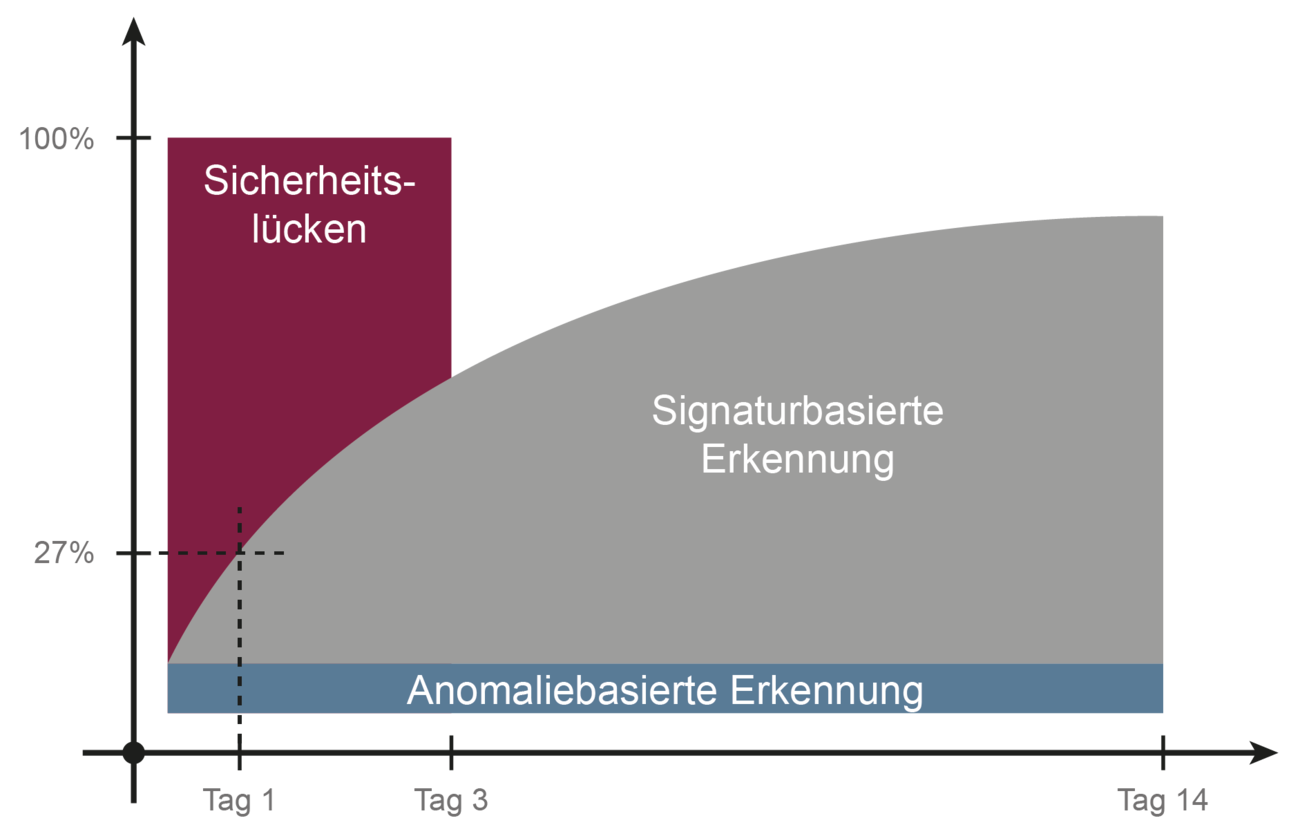

Risiken von ChatGPTChatGPT kann sich auf die IT-Sicherheit sowohl positiv als auch negativ auswirken. Bei der Nutzung von ChatGPT können folgende erhöhte Risiken auftreten: Phishing / Spear-PhishingMit einen Phishing-Angriff versuchen Cyberkriminelle zum Beispiel mithilfe von gefälschten E-Mails IT-Systeme von Opfern mit Malware zu infizieren. Dazu sendet der Angreifer zum Beispiel hunderttausend E-Mails, die er aus dem Darknet erworben hat. Wenn davon nur 50 auf diesen Angriff reinfallen, ist das ein sehr großer Erfolg. Diese 50 IT-Systeme sind dann mit Malware infiziert und der Angreife kann diese dann für verschiedenste Angriffe nutzen.  Bei Spear-Phishing werden im Vergleich zu Phishing individuelle Empfänger sorgfältig ausgewählt und über sie recherchiert. Die Opfer sind zum Beispiel Administratoren von Unternehmen, die besonders viele Rechte der IT-Infrastruktur eines Unternehmens haben. Als Vorbereitung analysieren Angreifer in Sozialen- und Berufsnetzwerk, welche Hobbys oder besondere Interessen das ausgesuchte Opfer hat. Aus diesen persönlichen Daten werden dann von dem Angreifer Spear Phishing Mails formuliert. Da diese auf das Opfer persönlich zugeschnitten, wirken sie viel glaubwürdiger und haben eine höhere Erfolgsaussicht. Das ist aufwendig und bedarf einiges an Kompetenzen, die in der Regel die Angreifer nicht selbst haben.  Mit den neuen Sprachmodellen wie ChatGPT sind die Cyberkriminelle in der Lage, hochgradig individuelle AI-Spear-Phishing-Mails zu generieren, die deutlich wirksamer und gefährlicher sind. Mit der Einbindung von ChatGPT werden Spear-Phishing-Mails automatisiert mit den vielen verfügbaren personenbezogenen Daten im Internet erstellt. Dadurch haben diese AI-Spear-Phishing-Mails eine höhere Vertrauenswürdigkeit und Erfolgsaussichten.  Angreifer aus dem Ausland können mit ChatGPT fehlerfrei deutschsprachige Texte schreiben. Die Texte sind von hoher Qualität, da sie den Stil des gefälschten Senders nachahmen und das macht sie besonders erfolgreich. Fortschrittliches Social EngineeringDie Tatsache, dass ChatGPT menschenähnlich antwortet, macht Betrug mittels Social Engineering wesentlich einfacher. In Kombination mit KI-generierten Bilder von Personen, Audio-Imitationen und Deepfake-Videos stehen den Angreifern Techniken zur Verfügung, um moderne Social-Engineering-Ansätze sehr gut und einfach umzusetzen. Das ist eine ideale Voraussetzung für CEO-Angriffe. ChatGPT hilft bei CEO-Angriffen die notwendigen Texte im Stil des CEO zu erstellen. In Verbindung mit einem Anrufer-ID-Spoofing kann der Angreifer zum Beispiel den Finanz-Manager anrufen, der in seinem Display dargestellt bekommt, dass der CEO anruft. Im Bild heißt der CEO Jan Janssen.  Der von ChatGPT erstellte Text wird in der Sprache des CEO umgewandelt und der Angriff kann erfolgen. Der CEO sagt dann zum Beispiel dem Finanz-Manager, sofort einen Geldbetrag auf ein bestimmtes Konto zu überweisen, da dadurch ein wichtiges Geschäft umgesetzt werden kann. Beschleunigtes Entwickeln von AngriffenBei der Erstellung von Malware und weiteren Angriffstechnologien kann ChatGPT als wertvolles Hilfsmittel genutzt werden. Es ist zurzeit nicht möglich, dass weniger erfahrene Angreifer ohne jegliche Programmierkenntnisse per Knopfdruck funktionierende Malware erstellen können. Überwindung des „Leere Blatt Syndroms“  Aber wenn ein erfahrender Programmierer ChatGPT als Assistent nutzt, ist er deutlich schneller als ohne. Der Angreifer gibt seine Anforderung ein und erhält dann von ChatGPT einen Programmcode, den der Angreifer noch optimieren muss und eventuell Fehler beseitigen muss. Dadurch sind die Angreifer deutlich schneller in der Programmierung von Angriffstools. Polymorphe MalwareBei ChatGPT kann durch wiederholtes Fragen die Antwort, also in diesem Fall der Code variieren oder mutieren. Dadurch kann mithilfe von ChatGPT einfach und automatisiert der Code geändert und polymorphe Malware umgesetzt werden. Hierdurch wird die Erkennungsrate durch Schutzmechanismen sinken.  Viele Anti-Malware-Lösungen arbeiten mit signaturbasierter Erkennung von Malware. Die Idee ist, dass wenn eine neue Malware entdeckt wird, von den Anti-Malware-Hersteller eine Angriffs-Signatur erstellt wird, die an alle verteilt wird, damit allen anderen, die diese Anti-Malware-Lösung haben, diese auch erkennen können. Nach einer gewissen Zeit kann dann insgesamt für alle eine hohe Erkennungsrate erreicht werden zum Beispiel nur 90 %. Wenn die Malware aber jedes Mal anders ist (polymorphe), funktioniert diese Methode nicht mehr und die Erkennungsrate wird sehr gering, zum Beispiel nur 27 %. Aus diesen Gründen ist in Zukunft insgesamt mit mehr Malware- bzw. Ransomware-Vorfällen zu rechnen. Vertrauliche InformationenDie Inputs, die bei ChatGPT eingegebenen werden, beinhalten in vielen Fällen vertrauliche, sensible Informationen, nach einer Studie 11 % bei ChatGPT. Beispiele für die Nutzung von vertraulichen, sensiblen Informationen:

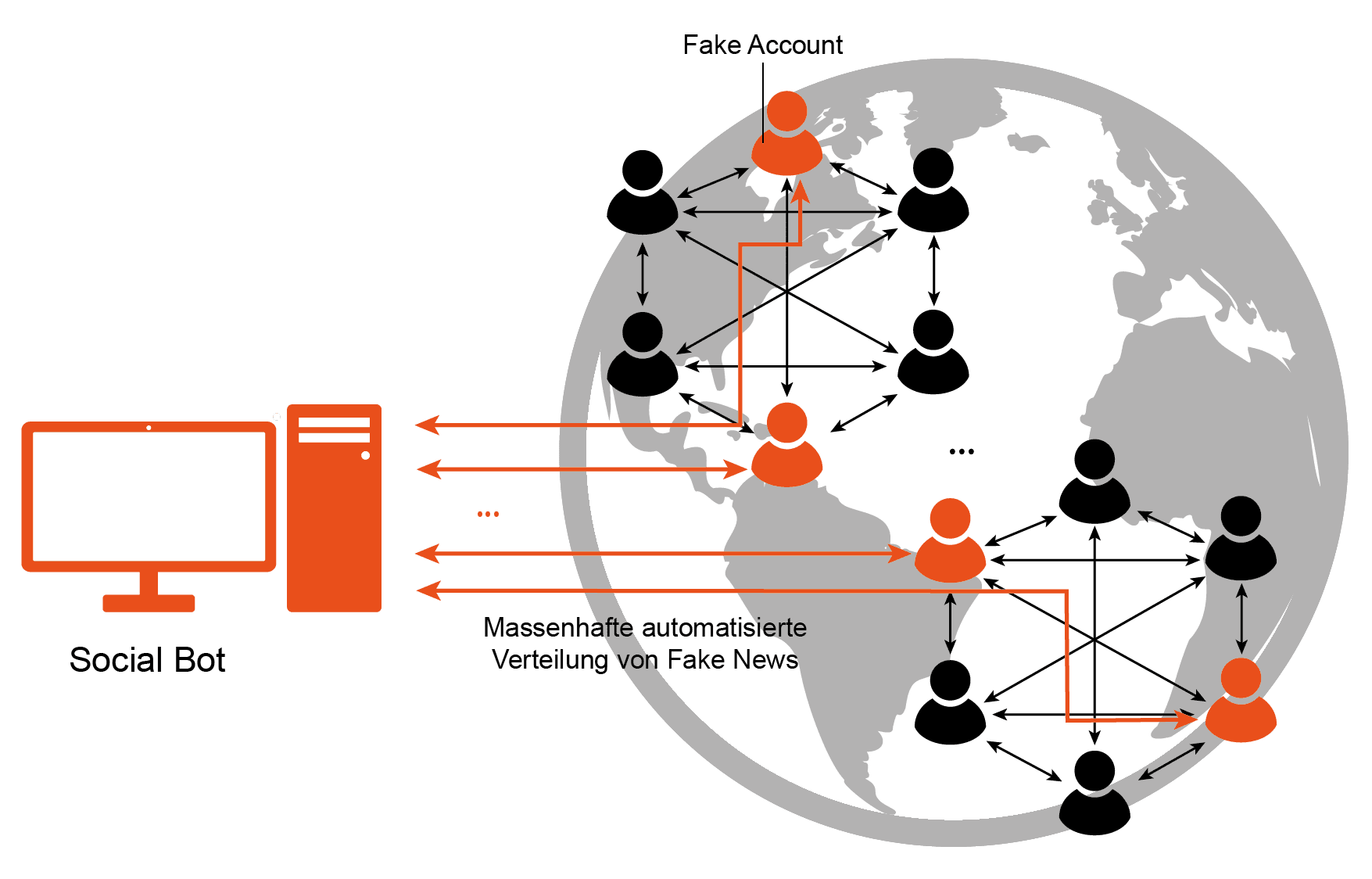

Im Prinzip sollen Daten, die in ChatGPT eingegeben werden, für das Trainieren des KI-Modells genutzt werden, um diese zu verbessern. Ob ChatGPT dies tut oder nicht, ist nicht einfach zu überprüfen. Die Eingabe von vertraulichen, sensiblen Informationen stellt eine neue und zusätzliche Angriffsfläche für die vertraulichen, sensiblen Informationen dar, was das Risiko vergrößert. Verbreitung von FalschinformationenChatGPT kann auch digitale Propaganda-Maschinen (Social Bots) unterstützen. Social Bots sind Meinungsrobotoren, die z. B. in sozialen Netzwerken gezielt Meinungen oder Fake News verteilen.  Social Bot erstellen in den verschiedenen sozialen Netzwerken Fake-Accounts. Mit ChatGPT kann die Profildarstellung der nicht existierenden Personen nach den gewünschten Kriterien erstellt werden. Dadurch kann auch die Aufnahme in gewünschten Echokammern motiviert werden. Mit überzeugteren und authentischeren Inhalten können die Botschaften, die über die Social Bots verteilt werden, erfolgreicher sein, um Stimmungsbilder zu beeinflussen und mehr Follower zu generieren. Ziele, die von den Angreifern verfolgt werden, sind zum Beispiel Manipulationen von Wahlen, Börsenkurse beeinflussen, politische Manipulationen beauftragt durch Geheimdienste oder Terrorgruppen umsetzen und das Durchführen von Cyber-Mobbing, insbesondere Personen, Unternehmen und Produkte diskreditieren. Zukunftsaussichten von ChatGPT auf die Cyber-Sicherheit

Weitere Informationen zum Begriff “ChatGPT und Cyber-Sicherheit“:„Chancen und Risiken von ChatGPT – Vom angemessenen Umgang mit künstlicher Sprachintelligenz“ „Ein Quantum Bit. Quantencomputer und ihre Auswirkungen auf die Sicherheit von morgen“ „Alexa, wie sicher bist du? – Intelligente Sprachsteuerung unter der Lupe“ „Das vernetze E-Auto als IoT-Gerät“ „Kontextsensitive CAPTCHAS im Online-Banking“ „Logdaten und Datenschutz? Kein Widerspruch!“ „Übungsaufgaben und Ergebnisse zum Lehrbuch Cyber-Sicherheit“ „Bücher im Bereich Cyber-Sicherheit und IT-Sicherheit zum kostenlosen Download“

„Hacker als Berufsbild – Das Projekt: Cyber Security Challenge Germany“ „Sicherheit in verteilten Netzwerken“

„Master-Studiengang Internet-Sicherheit (IT-Sicherheit, Cyber-Sicherheit)“ „Marktplatz IT-Sicherheit: IT-Notfall“ „Marktplatz IT-Sicherheit: IT-Sicherheitstools“ „Marktplatz IT-Sicherheit: Selbstlernangebot“ „Marktplatz IT-Sicherheit: Köpfe der IT-Sicherheit“ „Vertrauenswürdigkeits-Plattform“ Zurück zur Übersicht Summary  Article Name ChatGPT und Cyber-Sicherheit Description ChatGPT stellt einen KI-basierten Assistenten für die Bereiche Cyber-Sicherheit und -Angriffe dar. Dies ermöglicht es sowohl Angreifern als auch Sicherheitsexperten, ihre jeweiligen Aufgaben auf professionellere Weise auszuführen und ihre Effektivität zu verbessern. Author Prof. Norbert Pohlmann Publisher Name Institut für Internet-Sicherheit – if(is) Publisher Logo  |

| |